Blogue

Brèche de sécurité dans des algorithmes d’IA : quand retracer des informations personnelles devient aussi facile que de réussir un Sudoku

En les interrogeant avec quelques données associées à un individu, les algorithmes de type « forêt aléatoire » pourraient révéler toutes les informations manquantes à son sujet, de la même façon qu'on remplit la grille d’un Sudoku. (Image générée par DALL-E-3 et Photoshop)

Des algorithmes d’intelligence artificielle (IA) entraînés sur des données personnelles anonymisées prennent leur place dans une panoplie de secteurs pour améliorer et accélérer la prise de décisions. Une équipe de Polytechnique Montréal soulève toutefois un drapeau rouge pour certains d’entre eux dans une étude qui vient de paraître : les algorithmes de type « forêt aléatoire » pourraient facilement dévoiler les données utilisées pour les entraîner. Un travail qui remet non seulement en question l’utilisation que l’on fait de ces algorithmes… mais aussi du recours aux données anonymisées.

Tout le monde s’est déjà frotté les méninges à une grille de Sudoku. Avec quelques informations de départ, on déduit l’endroit où ajouter chacun des chiffres manquants. Parfois on se trompe, mais le défi reste divertissant.

Imaginez maintenant que l’on remplace les chiffres par vos informations personnelles. Avec seulement votre taille, une adresse et votre année de naissance pour informations, on pourrait par exemple récupérer l’ensemble de vos données médicales ou obtenir votre statut de crédit. Sans doute trouveriez-vous le jeu moins amusant.

N’empêche, ce scénario pourrait bien s’avérer dans un futur pas si lointain.

Des algorithmes faillibles

Le professeur Thibaut Vidal (Photo : Thierry du Bois) Le professeur Thibaut Vidal (Photo : Thierry du Bois) |

Voilà ce qu’avance une équipe de Polytechnique Montréal dirigée par Thibaut Vidal, professeur agrégé au Département de mathématiques et de génie industriel, dans une étude présentée en juillet dernier à la 41e International Conference on Machine Learning à Vienne, en Autriche - l'une des plus réputées en apprentissage machine sur la planète, où seulement 160 des 10 000 articles soumis sont sélectionnés pour une présentation orale. Le groupe de recherche soulève dans son article des questions sur la confidentialité des données utilisées pour entraîner certains modèles d'intelligence artificielle (IA).

Le travail mené par Julien Ferry, Ricardo Fukasawa, Timothée Pascal et le professeur Vidal - tous associés à la Chaire SCALE-AI de Polytechnique Montréal - démontre qu’un type précis d’algorithme utilisé en intelligence artificielle s’avère problématique : celui des forêts aléatoires ou random forest en anglais. On utilise ces algorithmes pour réaliser différentes fonctions, notamment le tri des courriels afin d’éliminer les pourriels, ou pour effectuer du ciblage publicitaire sur les réseaux sociaux. On s’en sert également en diagnostic médical ou pour analyser le crédit d’un individu parmi plusieurs autres fonctions.

Et c’est surtout pour des utilisations comme celle-là que le bât pourrait blesser.

« Les modèles d'apprentissage automatique comme les forêts aléatoires sont des outils puissants qui peuvent extraire des corrélations et des informations à partir de grandes quantités de données sans pour autant stocker les noms et les attributs spécifiques d’une personne, explique le professeur Vidal. L’outil y va par associations, et comme beaucoup des profils utilisés pour l’entraînement sont quasiment uniques, l’algorithme encode intrinsèquement une grande partie des données d'entraînement dans sa structure comme on le démontre dans l’étude. »

Utilisons un exemple pour bien comprendre. Votre voisin a accepté que ses données médicales soient utilisées pour entraîner l’outil de diagnostic d’un centre hospitalier. Un esprit malveillant a de son côté certaines informations le concernant : sa taille, son âge et le code postal de sa résidence. En utilisant ces données ainsi que le modèle entraîné par le centre hospitalier, la personne pourrait hypothétiquement obtenir une partie des informations concernant votre voisin, et ce, même si les données utilisées pour l’entraînement étaient anonymisées.

Un dilemme en vue

Toute l’histoire ne serait pas alarmante si l’accès aux modèles entraînés était protégé. Or, les techniques de protection existantes sont loin d’être adoptées par l’ensemble des secteurs en raison de leur difficulté d’application ou du coût résultant en termes de performances prédictives, selon le professeur Vidal. De nombreux modèles sont même dévoilés directement ou indirectement pour des raisons de transparence ou d’audit. L’article 13 de l’AI Act européen impose par exemple de telles contraintes de transparence pour les systèmes d’intelligence artificielle dits « à haut risque », tels que les dispositifs médicaux ou les logiciels de recrutement. « Cela présente un véritable enjeu », explique le professeur Vidal. « D'une part, il est souvent nécessaire de divulguer ces modèles, mais d’autre part, la confidentialité et la sécurité des données personnelles constituent des exigences légales. »

Selon lui, il est impératif que les entreprises et les chercheurs prennent des mesures pour assurer la protection des données tout au long du développement et de l'utilisation des modèles d'apprentissage. « Cela inclut l'adoption de pratiques éthiques de collecte de données, l'utilisation de techniques de protection des données telles que la confidentialité différentielle, et la sensibilisation des utilisateurs à l'importance de la confidentialité des données », précise-t-il.

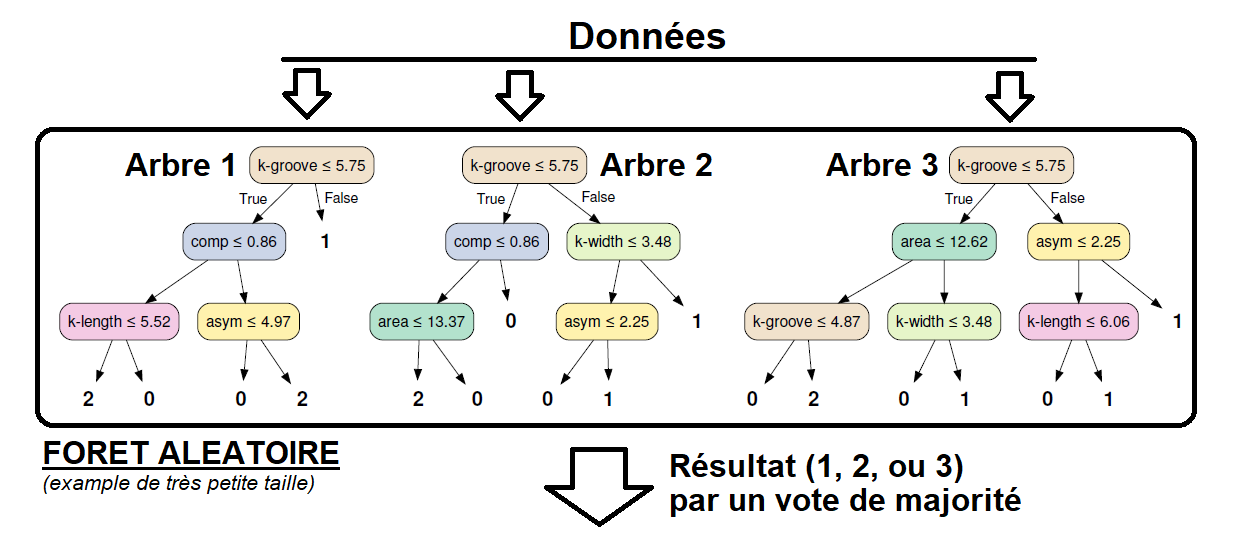

Coup d'oeil sur... Les algorithmes de type « forêt aléatoire » |

|

Les algorithmes de type « forêt aléatoire » sont réputés pour leur robustesse et leur capacité à traiter de grandes quantités de données. Ils fonctionnent en combinant les prédictions de plusieurs arbres décisionnels, chacun construit à partir d'un sous-ensemble aléatoire des données d'entraînement. Cette diversité des arbres permet de réduire les erreurs et d’améliorer la précision globale du résultat final. Pour démontrer l’incapacité des modèles basés sur ce type d’algorithme à protéger les données d’entraînement, l’équipe de Polytechnique Montréal a misé sur un nouveau paradigme d'attaque qui consiste à utiliser des outils dits « d'optimisation combinatoire » pour encoder précisément les informations fournies par le modèle et reconstruire une nouvelle version des données d'entraînement cohérente avec sa structure. L’approche de reconstruction des données ressemblait ainsi d’une certaine façon à la stratégie qu’on emploie pour remplir les cases d’une grille de Sudoku. « C’est un problème difficile à résoudre à grande échelle, mais les algorithmes spécialisés pour ce type de résolution peuvent déjà traiter des cas incluant des milliers d’exemples d’entrainements et des centaines d’arbres, explique le professeur de Polytechnique. Les erreurs de reconstruction frôlent souvent le 0 %, ce qui signifique que l’attaquant retrouve l’intégralité des données d’entrainements avec une grande précision. » |

En savoir plus

Fiche d'expertise du professeur Thibaut Vidal

Site du Département de mathématiques et génie industriel

L'étude Trained Random Forests Completely Reveal your Dataset admise pour une présentation orale à la 41e International Conference on Machine Learning

Commentaires

Commenter

* champs obligatoire