Le Magazine de Polytechnique Montréal

Solutions technologiques pour une ville connectée

Intelligente, connectée, efficiente, durable : derrière les promesses de la ville de demain se tiennent des enjeux scientifiques reliés à la production et la gestion des données produites par les infrastructures, les réseaux et les usagers. Plusieurs chercheurs de polytechnique consacrent leurs travaux au développement de solutions technologiques pour les infrastructures « communicantes » nécessaires à la numérisation de l’univers urbain. Nous vous proposons un éventail de certains de ces travaux.

LE DÉFI DE L’EXPLOITATION DES DONNÉES

Martin Trépanier est professeur titulaire au Département de mathématiques et de génie industriel. Si la ville intelligente l’intéresse, il la regarde sous l’angle des systèmes d’information en logistique et planification des transports. Il travaille avec des données de mobilité urbaine, les données des cartes à puce des sociétés de transport en commun, par exemple, ainsi qu’avec des données d’autopartage (soutenu par Communauto et le CRSNG), de télémétrie des autobus et des équipements de déneigement, le plus souvent en collaboration avec la Chaire Mobilité de la Pre Catherine Morency.

Martin Trépanier est professeur titulaire au Département de mathématiques et de génie industriel. Si la ville intelligente l’intéresse, il la regarde sous l’angle des systèmes d’information en logistique et planification des transports. Il travaille avec des données de mobilité urbaine, les données des cartes à puce des sociétés de transport en commun, par exemple, ainsi qu’avec des données d’autopartage (soutenu par Communauto et le CRSNG), de télémétrie des autobus et des équipements de déneigement, le plus souvent en collaboration avec la Chaire Mobilité de la Pre Catherine Morency.

Pour lui, l’un des plus grands défis des villes intelligentes concerne les données. S’il y a beaucoup de technologies pour en collecter, le défi réside dans leur exploitation. Encore faut-il d’abord s’assurer de leur intégrité. L’approche utilisée pourrait être jugée classique, d’un point de vue du traitement des données. Le défi scientifique est lié à la très grande quantité de données. « Avant de les utiliser, explique le Pr Trépanier, il faut d’abord s’assurer de bien décrire les données — savoir exactement ce qu’on a, de manière quantitative et qualitative. Souvent, on doit les compléter; avec les données de cartes à puce dans les réseaux de transport en commun, par exemple, on voudra trouver des moyens de séquencer les données pour identifier l’origine et la destination. »

Ensuite, en collaboration avec le Pr Bruno Agard, on appliquera les techniques de fouille des données (data mining), pour creuser dans de grands ensembles de données afin de retrouver des comportements ou des groupes (clusters) similaires.

Finalement, on cherche à identifier des modèles pour prédire des données ou mieux les expliquer. C’est ensuite qu’on peut les visualiser, par exemple, pour les utiliser dans un contexte d’identification des problèmes, de planification ou d’optimisation des services. C’est à ce stade qu’on parvient à véritablement exploiter les données.

« Ce qui est intéressant, note Martin Trépanier, c’est que jusqu’à présent, on recueillait surtout les données à d’autres fins. Par exemple, dans les transports en commun, les cartes à puce servaient à collecter de l’argent, pas à faire de la planification. Les données de télémétrie de déneigement servaient plutôt à surveiller le fonctionnement des équipements en temps réel et à suivre la couverture du réseau visuellement. Ces procédés ne servaient pas à calculer des indicateurs de performance comme on peut le faire désormais. En fait, on trouve de nouvelles façons d’utiliser les données, un peu comme un effet secondaire! »

OPTIMISER LES OPÉRATIONS DE DÉNEIGEMENT

En collaboration avec son collègue André Langevin, professeur associé au Département de mathématiques et de génie industriel, Martin Trépanier s’est particulièrement intéressé à la problématique du déneigement. « Ce que nous analysons, explique le Pr Trépanier, ce sont les données de télémétrie liées aux véhicules, pour être en mesure de mieux connaître, modéliser et planifier les opérations de déneigement. »

Pour y arriver, le chercheur travaille, entre autres, avec des données fournies par la Ville de Granby dont les 11 véhicules utilisés pour le déneigement sont équipés pour recueillir des données de positionnement. Cette ville a ceci de particulier que son territoire est à la fois urbain et rural, ce qui n’est pas courant en matière de planification, souligne le Pr Trépanier.

« Dans un premier temps, mentionnet-il, on observe ce qui se fait et on fait un appariement entre les données et le réseau routier comme tel. On utilise ensuite des méthodes d’optimisation des parcours afin d’être capables d’améliorer la performance du service. Cela peut s’appliquer autant à l’épandage qu’au tassement et au ramassage de la neige. » Dans ce cas précis, le résultat a été l’éla boration d’un modèle capable de déterminer la quantité de sel à épandre en fonction de nombreux facteurs : la température de l’air, celle de la route, les précipitations, la présence de neige ou non, les heures d’ensoleillement, etc.

« Pour la Ville de Granby, on a surtout voulu déterminer des indicateurs de performance, poursuit le Pr Trépanier, mais dans le cas des cartes à puce, on a aussi élaboré des techniques de visualisation des données, avec des interfaces web, afin de pouvoir consulter ces grands ensembles de données de manière compréhensible. Dans le cas du déneigement, on parle surtout d’une représentation géographique plus classique, avec des cartes, pour répondre aux besoins de l’opérateur. »

À terme, les planificateurs visent à réaliser des économies et à mieux utiliser les équipements. Trouver la route optimale pourrait contribuer à atteindre cet objectif. « Mais on n’en est pas encore là, précise Martin Trépanier, parce qu’en matière de déneigement, les équipes sur le terrain travaillent par secteur, et ce sont les opérateurs des équipements qui planifient les parcours », en fonction de leur connaissance pratique des opérations. « C’est un défi à modéliser mathématiquement, parce qu’il y a de nombreuses règles opérationnelles : par exemple, il ne faut jamais laisser de bancs de neige, il faut toujours tourner à droite, etc. »

MIEUX PLANIFIER LES TRANSPORTS PUBLICS

Les cartes à puce des sociétés de transport public sont une importante source de données auxquelles Martin Trépanier peut trouver de nombreuses applications. L’analyse des déplacements de type « origine-destination » en fait partie.

Sauf que cet ensemble de données doit être reconstitué. « Comme on lit la carte au point d’entrée de l’usager, à Montréal par exemple, on a l’endroit d’origine, mais pas l’endroit de destination; on a donc développé un algorithme pour déterminer la destination en fonction des chaînes de déplacement. » Ces travaux ont été cofinancés par la compagnie Thales, un fabricant de systèmes de paiement par cartes à puce, le CRSNG et PROMPT-Québec.

Si l’algorithme permet d’associer des données liées à une carte spécifique, il utilise toutefois un identifiant de carte crypté qui ne permet pas d’identifier l’utilisateur de manière nominative par sa carte, pour des raisons évidentes de confidentialité.

« Par ailleurs, le système des cartes à puce ne fournit pas nécessairement le lieu géographique d’embarquement de l’usager, explique le Pr Trépanier. C’est le cas à Montréal, notamment, alors qu’on a un numéro de bus avec une date et une heure d’embarquement, et on doit associer ces données avec un système qui nous indique la position du bus. » Pour le moment, ce ne sont pas tous les autobus qui sont équipés pour capter le positionnement. Si c’est le cas de l’ensemble des autobus à Laval, seulement le tiers des autobus de Longueuil le sont et le sixième des autobus à Montréal, mais des projets en cours permettront de tous les équiper.

Martin Trépanier travaille également avec la Société de transport de l’Outaouais (STO) depuis une dizaine d’années. La STO est considérée comme un innovateur dans ce domaine, consignant des données de positionnement, de cartes à puce, etc., dans son système depuis 2001. « Cela lui a permis d’implanter un algorithme de destination pour élaborer des modèles d’origine-destination avec leurs données », ce qui n’est pas courant, affirme le Pr Trépanier.

« Ils peuvent savoir où vont les usagers et revoir leurs tracés afin d’améliorer leur service. »

Le Pr Trépanier cite en exemple la mise en place du Rapibus à Gatineau, un corridor pour autobus qui emprunte un ancien tracé de voie ferrée. « La STO a pu réorganiser son réseau en fonction de cette implantation, grâce aux données recueillies, souligne-t-il. Et actuellement, puisqu’on a les données avant et après (la mise en place du Rapibus), on peut comparer les situations et faire des analyses intéressantes. »

MODÉLISER LES EFFETS DOMINO

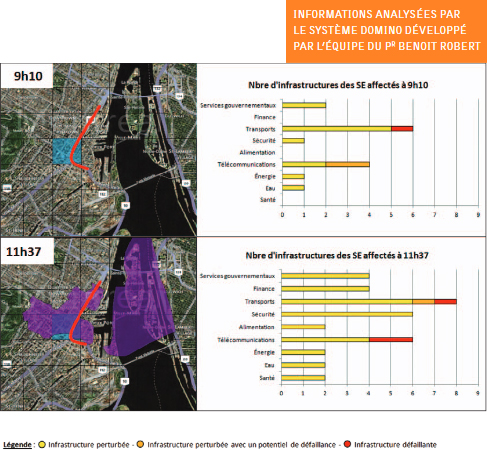

Lorsqu’une canalisation d’eau majeure cède, quels sont les impacts sur la circulation automobile? Voilà le genre de questions auxquelles tente de répondre le système Domino, mis au point par l’équipe du Pr Benoit Robert au Centre risque & performance (CRP) de Polytechnique Montréal (polymtl.ca/crp) en collaboration avec des partenaires publics et privés.

Lorsqu’une canalisation d’eau majeure cède, quels sont les impacts sur la circulation automobile? Voilà le genre de questions auxquelles tente de répondre le système Domino, mis au point par l’équipe du Pr Benoit Robert au Centre risque & performance (CRP) de Polytechnique Montréal (polymtl.ca/crp) en collaboration avec des partenaires publics et privés.

Domino est un système de gestion des interdépendances et d’analyse des effets domino constitué d’une base de données liée à un système d’information géographique. Le fonctionnement de l’outil repose sur une approche de gestion des risques basée sur les conséquences. L’outil vise à évaluer les propagations dans le temps des conséquences sur les réseaux d’une situation pouvant engendrer un effet domino sans, a priori, s’attarder aux causes ayant mené à cette situation.

Domino permet notamment de modéliser et de visualiser l’impact qu’une panne dans un réseau pourrait provoquer chez un ou plusieurs autres réseaux. Par exemple, un bris dans le réseau d’alimentation en eau potable dans un secteur donné pourrait avoir comme conséquence des perturbations dans un secteur du réseau de transport routier et potentiellement dans les réseaux de télécommunications et de transport en commun.

Au fil du temps, la zone d’impacts indirects du bris initial s’étend, démontrant de manière visuelle l’interdépendance entre divers réseaux.

Outil de planification et d’aide à la décision, Domino comprend plusieurs modules qui permettent des utilisations autant par les gestionnaires des réseaux que par les responsables de la sécurité civile. Il traite les interdépendances fonctionnelles en analysant les relations de type client/fournisseur existant entre les réseaux.

Récemment, le CRP a annoncé qu’il travaillait avec ses partenaires à un projet qui permettra d’intégrer Domino à la nouvelle solution d’Infrastructure géomatique ouverte (IGO) (igouverte.org) développée en logiciels libres, sous un mode d’accès restreint.

AMÉLIORER LA SÉCURITÉ ROUTIÈRE

Recueillir des données pour le diagnostic intelligent de la sécurité routière est le sujet de prédilection de Nicolas Saunier, professeur agrégé au Département des génies civil, géologique et des mines. Pour ce faire, il s’intéresse particulièrement à l’analyse des images vidéo de la circulation, par exemple aux carrefours, dans le but d’évaluer les risques de collisions.

La méthode qu’il utilise, en collaboration notamment avec son collègue Luis Miranda-Moreno, de l’Université McGill, s’inspire fortement d’une approche développée notamment en Suède dans les années 70. Selon un protocole établi, des observateurs humains analysent visuellement et sur place le déplacement des véhicules, les vitesses, etc., et relèvent ainsi les conflits entre les usagers de la route. Ces données servent à mesurer la sécurité routière. Dans ses recherches, le Pr Saunier remplace les observateurs humains par une caméra vidéo installée au site étudié sur une perche télescopique fixée sur une infrastructure existante, comme un lampadaire. Puis, avec des algorithmes, il analyse les images pour en extraire automatiquement des indicateurs de sécurité, par exemple le « temps à la collision ».

Le temps à la collision exprime, à un instant donné, le temps qui sépare deux usagers (conducteurs, piétons ou cyclistes) d’une collision, si aucun des usagers ne modifie sa trajectoire. Compte tenu du temps de perception-réaction des sujets, plus le temps à la collision est court, plus le risque de collision est élevé.

Cette méthode est utilisée pour comparer les observations avant et après un aménagement visant l’amélioration de la sécurité, de manière à mesurer l’effet précis de cet aménagement, en supposant que toutes les autres conditions sont demeurées similaires. Ce fut le cas dans une étude des « sas pour vélos », un espace peint où les vélos peuvent se placer devant les voitures à la ligne d’arrêt d’un carrefour. Il y en a sept à Montréal, dont le premier fut installé sur la rue Milton à l’intersection de la rue University.

« On a constaté un impact plutôt positif, explique le Pr Saunier. On a pu observer une réduction des infractions, par exemple moins de violations des feux rouges, et notamment une baisse des infractions qui se doublaient de situations dangereuses. En profitant de cet aménagement, les cyclistes augmentent leurs marges de sécurité avec les véhicules motorisés. »

L’analyse vidéo sera utilisée, par exemple, pour étudier l’effet de l’implantation de panneaux d’arrêt toutes directions à des carrefours à Montréal, un projet de recherche auquel participera le professeur Saunier avec des collègues de McGill et de l’INRS.

L’analyse vidéo permet aussi d’estimer de façon plus précise le temps nécessaire pour traverser une rue à pied, propose Nicolas Saunier. « On peut évaluer quelle proportion de la population, comme les enfants ou des personnes à mobilité réduite, peut être mise en danger selon le temps alloué pour traverser. »

La prochaine étape? Des images captées par des drones. « Nos caméras ont un angle assez faible par rapport à la route, ce qui présente des risques de masquage entre les usagers. Un drone qui filme au-dessus d’un carrefour nous donne une image globale de la situation, sans interférence. »

Selon les plus récentes données de Transports Canada, il y a eu 1 741 collisions mortelles impliquant des voitures et 120 660 collisions avec blessures au Canada en 2013. Si ces indicateurs sont en baisse depuis les 20 dernières années, il est clair qu’on peut encore apporter beaucoup d’améliorations à la sécurité routière. Et Nicolas Saunier espère bien que ses travaux y contribueront.

L’APPRENTISSAGE MACHINE À LA RESCOUSSE DES INFRASTRUCTURES VIEILLISSANTES

De nombreuses villes dans le monde, et Montréal n’y fait pas exception, font face au problème du vieillissement de leurs infrastructures, conséquence de décennies de sous-financement chronique*. Le coût pour remplacer ou mettre à niveau massivement les infrastructures désuètes serait hors de portée des pouvoirs publics. Alors comment faire primer la sécurité et la gestion durable? Le Pr James-A. Goulet propose une solution qui fait appel à des techniques tirées de l’apprentissage machine et de l’intelligence artificielle.

Dans le contexte économique actuel, une des nouvelles voies qui s’offrent aux ingénieurs civils est celle de la surveillance électronique des infrastructures, afin d’intervenir de manière préventive lorsqu’elles donnent des signaux alarmants. Autrement dit, il leur faut gérer la vétusté des infrastructures.

« La technologie nous permet de recueillir de l’information en continu sur l’état des structures, explique James-A. Goulet. En installant des capteurs qui fournissent des données sur les déplacements, rotations, déformations ou accélérations subies par les structures, ainsi que sur les conditions environnementales, il est possible d’inférer l’état des structures à partir de leur comportement. »

« La technologie nous permet de recueillir de l’information en continu sur l’état des structures, explique James-A. Goulet. En installant des capteurs qui fournissent des données sur les déplacements, rotations, déformations ou accélérations subies par les structures, ainsi que sur les conditions environnementales, il est possible d’inférer l’état des structures à partir de leur comportement. »

De tels capteurs équipent quelques ouvrages, comme le pont Champlain ou l’échangeur Turcot. « Étendre leur usage à un grand nombre d’infrastructures afin d’en améliorer la gestion représenterait une solution économiquement viable, car ces appareils de mesures performants sont devenus relativement peu coûteux et disponibles à grande échelle », fait valoir le P r Goulet.

Se pose toutefois un défi de taille : comment traiter ces informations pour prendre les bonnes décisions d’intervention? « Il y a des dizaines de milliers d’infrastructures vieillissantes au Canada. Il n’est donc pas envisageable de créer un modèle détaillé du comportement de chacune d’elles. Il faut un modèle adaptable à un grand nombre de structures qui sont différentes les unes des autres, précise le Pr Goulet. On rencontre deux grandes difficultés : le nombre gigantesque de données générées par un grand parc d’infrastructures, et les données manquantes ou aberrantes, difficiles à distinguer des données réellement alarmantes. » Ces difficultés proviennent de la complexité des relations entre les infrastructures et leur environnement.

Pour interpréter correctement les données, James-A. Goulet emploie des méthodes issues de l’apprentissage machine et de l’intelligence artificielle, qu’il allie aux expertises du génie civil. « En nous basant sur les théories de la probabilité et de la décision, nous obtenons des algorithmes capables d’apprendre à identifier un comportement normal et à détecter les données aberrantes afin de ne pas en tenir compte dans leurs calculs. Une fois le comportement normal appris, on peut détecter toute déviation », commente-t-il, en soulignant que ce type de raisonnement cognitif combiné à la puissance de calcul d’un ordinateur surpasse les capacités de l’humain dans la tâche de détecter des anomalies dans le comportement des structures. Les travaux de recherche du Pr Goulet visent maintenant à rendre les modèles génériques développés capables de s’autocalibrer. Cette capacité est un aspect clé pour que les solutions développées soient extrapolables à des milliers de structures différentes.

Ces solutions promettent d’optimiser considérablement la gestion des infrastructures. « Convaincre les décideurs publics et privés de partager davantage leurs données avec les chercheurs demeure toutefois un défi », mentionne le Pr Goulet, qui se réjouit par ailleurs que ses travaux permettent de former une nouvelle génération d’ingénieurs civils capables de tirer avantage des domaines de l’apprentissage machine et de l’intelligence artificielle.

* Une étude publiée par le Centre canadien des politiques alternatives en 2013 chiffrait le déficit à 145 milliards de dollars pour le Canada.

MONTRÉAL SE CONNECTE AVEC LES CHERCHEURS POUR SON PROJET DE VILLE INTELLIGENTE

Montréal a l’ambition d’être internationalement reconnue, dès 2017, comme chef de file parmi les villes intelligentes et numériques. Déjà classée parmi les 21 métropoles intelligentes de l’année 2016 par l’Intelligent Community Forum (ICF) en octobre dernier, elle vient d’être sélectionnée par le même organisme parmi les sept communautés les plus dynamiques et inspirantes en matière de ville intelligente.

Pour Harout Chitilian, vice-président du comité exécutif de la Ville de Montréal et responsable des technologies de l’information et de la ville intelligente et numérique, il est certain que pour réaliser son objectif, Montréal doit miser sur une de ses plus abondantes ressources : la matière grise!

Pour Harout Chitilian, vice-président du comité exécutif de la Ville de Montréal et responsable des technologies de l’information et de la ville intelligente et numérique, il est certain que pour réaliser son objectif, Montréal doit miser sur une de ses plus abondantes ressources : la matière grise!

« Montréal est une ville universitaire de premier plan, c’est un creuset pour les innovations. Nous visons un rapprochement avec les chercheurs de nos universités pour favoriser l’émergence de solutions permettant l’utilisation des données massives issues de diverses sources », déclare-t-il. Ces partenariats peuvent en particulier se réaliser avec des regroupements de recherche tels que le Centre de recherche informatique de Montréal (CRIM) ou IVADO, l’institut de valorisation des données créé par Polytechnique, HEC et l’Université de Montréal.

Ce diplômé de Polytechnique souligne que les principaux défis de la ville intelligente sont moins technologiques qu’organisationnels ou de gouvernance. « Les villes, tout comme les organisations, sont structurées pour fonctionner dans les anciens systèmes. Avec l’avènement des architectures de données ouvertes et flexibles, l’enjeu majeur, c’est le changement de culture opérationnelle. »

disponible (Hiver 2016)

disponible (Hiver 2016)