Blogue

L’IA au service de l’aide humanitaire

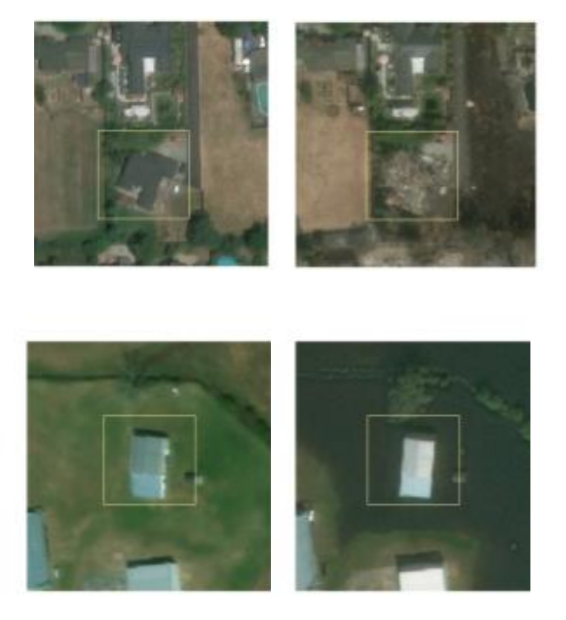

Parmi les images de catastrophes qui ont servi à entraîner l’outil d’intelligence artificielle développé par HEC Montréal et Polytechnique Montréal, on compte celles engendrées par le passage de l’ouragan Matthew dans les Antilles en 2016. (PHOTO : Haiti Hit by Hurricane Matthew, par United Nations Photo, licence CC BY-NC-ND 2.0)

Parmi les images de catastrophes qui ont servi à entraîner l’outil d’intelligence artificielle développé par HEC Montréal et Polytechnique Montréal, on compte celles engendrées par le passage de l’ouragan Matthew dans les Antilles en 2016. (PHOTO : Haiti Hit by Hurricane Matthew, par United Nations Photo, licence CC BY-NC-ND 2.0)

Après un tremblement de terre, un incendie de forêt ou un ouragan, les secours s’en remettent bien souvent à des images satellitaires pour déterminer où sont les besoins les plus pressants à la suite d'une catastrophe naturelle. Un travail qui demande plusieurs heures d’analyse, voire des jours. Une équipe de Polytechnique Montréal et de HEC Montréal a tenté d’automatiser le processus par intelligence artificielle (IA). Grâce à elle, on s’approche un peu plus d’une solution applicable sur le terrain.

Tremblement de terre à Haïti en janvier 2010, feux de broussaille en Australie en 2019, ouragan ou, plus près de nous, ces inondations importantes en Colombie-Britannique en 2021 : lorsque des catastrophes naturelles d’envergure surviennent, les secours s’organisent tant bien que mal avec les ressources sur place, et ce, malgré des télécommunications et des transports défaillants.

Sur le terrain, plusieurs stratégies sont mises en place pour évaluer l’étendue des dommages et prioriser les interventions. Aux relevés terrains et aériens s’ajoutent parfois ceux de drones, puis d’images satellitaires lorsque la météo coopère et que la vue des caméras n’est pas obstruée par des nuages ou du brouillard.

Le problème, c’est qu’analyser ces images en détail prend des jours selon les ressources mises à la disposition des secours. Pendant ce temps, un compte à rebours est déjà enclenché pour de nombreuses vies humaines.

L’apprentissage automatisé en appui aux secours

Isabelle Bouchard (PHOTO : courtoisie d'Isabelle Bouchard)

|

Dans le cadre de ses travaux de maîtrise en génie informatique, Isabelle Bouchard a cherché à faciliter le travail des équipes d’aide humanitaire en automatisant l’analyse des images par « apprentissage machine », cette forme d’intelligence artificielle la plus couramment employée.

Objectif : présenter à l’algorithme d’apprentissage des centaines de milliers de photographies satellitaires captées avant et après un sinistre pour qu’il identifie ce qui a changé. Une fois entraîné, pareil outil pourrait effectuer le travail de façon autonome et identifier, par exemple, quelles sont les régions d’un territoire où les bâtiments ont été le plus affectés par le passage d’un ouragan, ou les racoins devenus difficiles d’accès à la suite d'une inondation majeure.

« Jusqu’ici, d’autres équipes avaient entraîné des algorithmes, mais en validant leur travail sur les mêmes catastrophes naturelles qui avaient servi à l’entraînement », explique l’ingénieure biomédicale de formation. « Ces algorithmes ne fonctionnent pas dans un contexte d’aide humanitaire où les images proviennent d’une nouvelle région du monde. »

La composition des images aériennes varie considérablement d’une région du monde à une autre, selon elle. La forme des bâtiments, ou même la couleur des toitures, par exemple, sont des éléments qui peuvent nuire à l’analyse que fera un algorithme de la situation. « Ce que les gens sur le terrain ont besoin, c’est d’un algorithme capable de généraliser la tâche et qui pourrait être en mesure de travailler malgré ces subtilités », précise-t-elle.

Sous la codirection de Pre Marie-Ève Rancourt, professeure au Département de gestion des opérations et de la logistique à HEC Montréal et de Daniel Aloise, professeur agrégé au Département de génie informatique et génie logiciel de Polytechnique Montréal, Isabelle Bouchard a entraîné un algorithme sur un jeu de données provenant de 18 sinistres qui ont eu lieu entre 2011 et 2019 un peu partout sur la planète.

Dans le lot, on trouve des images présentant le « avant/après » du passage d’un ouragan ou de feux de forêt. Les conséquences de séismes, d’inondations et même d’éruptions volcaniques ont aussi servi à l’entraînement de l’algorithme. Un ensemble de données « ouvert » mis à la disposition des équipes de recherche par la Defense Innovation Unit.

Coup d'oeil sur... l’apprentissage automatisé d’images de sinistres |

|

Celle qui est maintenant titulaire d’un diplôme de maîtrise en génie informatique a d’abord testé des algorithmes existants sur ses jeux de données déjà annotées, en utilisant 17 des 18 événements de catastrophes naturelles pour entraîner son algorithme, puis en testant ensuite l’outil sur le dix-huitième événement. « On s’est vite rendu compte que notre échantillon de 17 catastrophes était trop petit pour que l’apprentissage puisse être généralisé à un autre sinistre », indique-t-elle. « Même si on avait entre 5 000 et 35 000 images par événement, il y avait peu de diversité d’images pour chaque catastrophe pour que l’algorithme puisse appliquer son apprentissage à un sinistre qui aurait lieu à un autre endroit dans le monde. » À ce problème s’en ajoutait un autre : certaines catastrophes, comme les incendies ou les ouragans, affecteront directement les bâtiments alors que d’autres, comme les inondations, se limiteront à leur périphérie. Un outil généraliste devrait pouvoir discriminer toutes les formes de dommages. L’équipe de recherche a alors adopté une stratégie où 10 à 500 images d’une « nouvelle » catastrophe seraient annotées, puis présentées à un algorithme préentraîné pour qu’il apprenne à reconnaître les particularités spécifiques d’une région. Une technique connue sous le nom « d’apprentissage de transfert ». « C’était important pour nous de reproduire le contexte d’une urgence en réduisant le temps d’analyse des images le plus possible, explique Isabelle Bouchard. Le problème, c’est qu’annoter manuellement ces images prend beaucoup de temps et nécessite des ressources. » Pour cette raison, l’équipe conjointe HEC Montréal – Polytechnique Montréal a également testé une stratégie sans annotations manuelles des images, et donc non supervisée, où l’algorithme identifie lui-même les paramètres des photos qui ne sont pas à considérer lors de son analyse des dommages. « Pour l’instant, ce n’est pas concluant, mais il faudrait éventuellement que ce soit la solution », explique Isabelle Bouchard. « L’accès à encore plus de jeux de données est vraiment le principal facteur limitatif ici. » Selon elle, il faudra aussi s’assurer de compter sur des images mieux distribuées du point de vue géographique. Aucune des bases de données accessibles aux chercheurs, par exemple, ne comporte des images où l'on voit de la neige. « On ne sait pas du tout comment le modèle pourrait réagir dans ce genre de situation », ajoute-t-elle. Si ces jeux de données annotées devenaient un jour disponibles, la jeune scientifique croit que l’IA pourrait accélérer la vitesse de réponse des services humanitaires. « Si l’algorithme devient suffisamment généralisé et capable d’analyser des images pour tous les types de catastrophes, on pourrait analyser les images en quelques heures après les avoir obtenues. » |

En savoir plus

Fiche d’expertise de Pr Daniel Aloise

Fiche d’expertise de Pre Marie-Ève Rancourt

Site Web du Département de génie informatique et génie logiciel

Commentaires

Commenter

* champs obligatoire